28.05.2025

LLM Ajanlarında Bellek Neden Kritik? Kısa ve Uzun Vadeli Bellek Kullanımı

LLM ajanlarında bellek kullanımı neden kritik? Bu yazıda kısa ve uzun vadeli bellek sistemlerini, MemGPT, RAG ve hibrit yaklaşımlarla yapay zeka ajanlarında hafıza yönetimini detaylıca keşfedin.

Navigation

Büyük Dil Modeli (LLM) ajanları, bağımsız çalışan standart LLM’lerin yeteneklerini bellek ve otonomi ile genişletmektedir. Basit bir sohbet botu her yanıttan sonra önceki etkileşimleri unuturken, bir ajan önceki adımları veya konuşmaları hatırlayıp bunlardan öğrenebilir. Bellek özelliği, ajanların uzun süreli görevleri sürdürmesini, kişiselleştirilmiş etkileşimler sunmasını ve zaman içinde daha karmaşık akıl yürütme süreçlerini yönetmesini mümkün kılar. Kullanıcının tercihlerini hatırlayan ya da çok adımlı bir planı takip edebilen bir yapay zeka asistanı, sürekli olarak bağlam hatırlatılmasını gerektiren bir asistana göre çok daha faydalı olacaktır.

Ancak LLM ajanlarına bellek eklemek basit bir işlem değildir. Modelin sabit bağlam penceresinin ötesinde bilgi saklamak, gerektiğinde doğru bilgiyi getirmek ve bu bilgileri güncellemek için özel mimari bileşenlere ihtiyaç vardır.

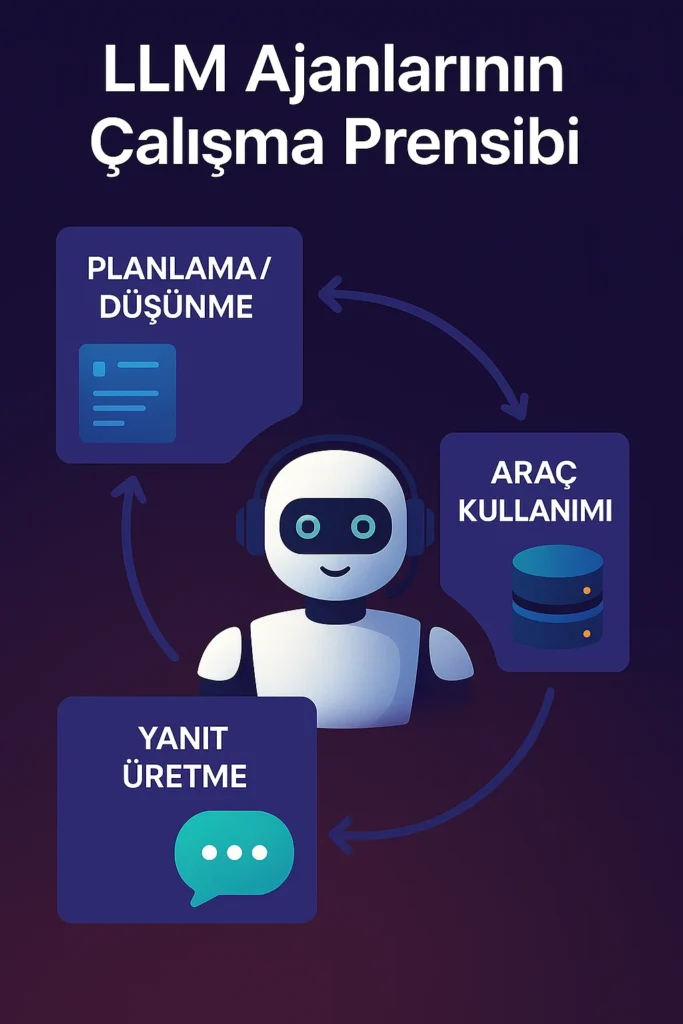

LLM Ajanlarının Çalışma Prensibi

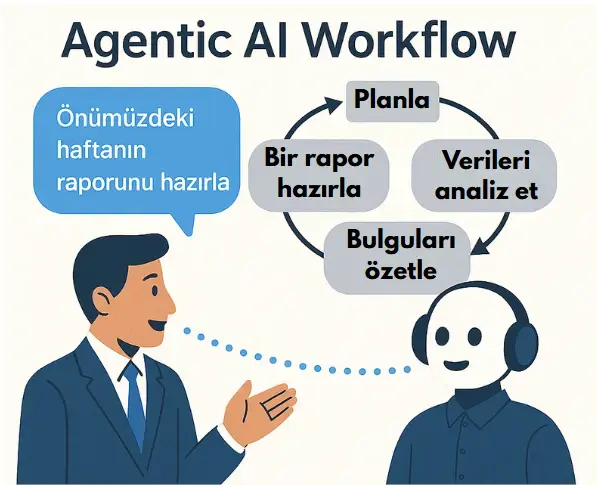

LLM ajanları, temel olarak, karar alma döngüsüyle donatılmış büyük dil modelleridir. Bu özellik, ajanların yalnızca tek seferlik konuşmalarla sınırlı kalmadan eylemleri otonom olarak planlayabilmesine, araçları kullanmasına ve çok adımlı çıktılar üretebilmesine imkan tanır. Basit bir sohbet robotu sadece son kullanıcı mesajına cevap verirken, bir ajan çok aşamalı akıl yürütme süreçleri gerçekleştirir. Genel olarak ajanlar, zincirleme düşünme (chain-of-thought) yöntemi ile plan yapar, eylemleri gerçekleştirir (araçlar veya API çağrıları gibi), elde edilen sonuçları gözlemler ve ardından bir sonraki adımı belirleyerek kullanıcıya bir cevap sunar. Bu döngü, tek bir kullanıcı sorgusu için birden fazla LLM çağrısını içerebilir. Örneğin, ajana “Merhaba, bugün benim doğum günüm!” mesajı geldiğinde süreç şöyledir:

- Planlama/Düşünme: Ajan öncelikle kullanıcının söylediği şeyi LLM kullanarak değerlendirir. Kullanıcıyı tanıyıp tanımadığını veya doğum günü bilgisine sahip olup olmadığını hatırlamaya çalışabilir veya bu bilgiyi hafızasından araştırmaya karar verebilir.

- Araç Kullanımı: Kullanıcının profili veya önceki sohbetlerinde doğum günü bilgisinin bulunup bulunmadığını kontrol etmek üzere bir bellek sorgulama aracı çağırabilir. Bellek aracı kullanıcının doğum gününün gerçekten bugün olduğunu doğrularsa, bu bilgi kullanılabilir.

- Yanıt Üretme: Son olarak ajan kişiselleştirilmiş bir yanıt oluşturur, örneğin “Doğum günün kutlu olsun! Seni görmek harika, [İsim]. Umarım harika bir gün geçiriyorsundur!” gibi hafızadan getirilen kullanıcının ismini içeren bir cevap oluşturur.

Bu otonomi, LLM’in yönlendirme (prompting) talimatlarını ve örnekleri takip ederek karar alabilme yeteneği sayesinde sağlanır. LangChain ve AutoGen gibi framework’ler genellikle bunu ReAct (Reason+Act) gibi yönlendirme stratejileri kullanarak uygularlar. Bu yöntemde LLM’den önce bir “Düşünce” ve ardından “Eylem” (örneğin, search_memory) üretmesi istenir. LLM doğal dilde eylemlerini “planlar” ve bu planlar ajan tarafından analiz edilip uygulanır. Araçlar, ajanın çağırabileceği fonksiyonlardır. Araç sonuçlarını bir sonraki LLM çağrısının yönlendirmesine dahil ederek ajan, planını adım adım gerçekleştirir.

Yönlendirme burada kritik bir rol oynar: Bir ajanın yönlendirmesi genellikle sistem mesajıyla başlar ve ajanın rolünü ve mevcut araçlarını tanımlar, ardından mevcut sohbet ya da bağlam ve son kullanıcı sorgusu gelir. LLM’in çıktısı analiz edilir: Eğer bir eylem ise ajan bunu uygular ve sonucu yönlendirmeye ekler; net bir cevap ise döngü sonlanır. Bu döngü karmaşık sorguları ele almak için gerektiği kadar tekrar edilir. Her adımda, ajan ne yaptığını ve ne öğrendiğini takip etmek durumundadır ve bellek burada devreye girer.

Bellek entegrasyonu iki şekilde gerçekleşebilir:

- Yönlendirme bağlamında: Ajanın geçmiş etkileşimleri veya alınan bilgiler LLM’in giriş bağlamına eklenir (örneğin sohbet geçmişi). Böylece LLM, bir sonraki adım veya cevabı planlarken önceki bilgileri dikkate alır.

- Araç olarak: Ajanın Recall veya StoreMemory gibi açık bellek işlemleri olabilir. Örneğin, ajan “Bu bilgiyi hatırlamalıyım” diyerek araç çağırabilir ve veriyi uzun süreli depolamaya kaydeder. Daha sonra ilgili bilgileri almak için başka bir araç kullanabilir. Bu tür araç tabanlı bellek kullanımı, bazen kendi kendini düzenleyen bellek (self-editing memory) olarak adlandırılır, çünkü ajan kendi bellek içeriğini yönetmek için LLM çağrılarını kullanır.

LLM Ajanlarında Bellek

LLM tabanlı ajanlar belleklerini iki temel kategori altında yapılandırırlar:

Kısa Vadeli Bellek (Short-Term Memory – STM)

Kısa vadeli bellek, bir LLM ajanın belirli bir görev veya sohbet oturumu sırasında kullandığı, LLM’in bağlam penceresine sığabilen, anlık ihtiyaç duyulan bilgileri tutan çalışma belleğidir. Genellikle şu anki sohbetin son birkaç mesajını, ara çıkarımları veya yakın zamanda gerçekleşen araç (tool) çağrılarının sonuçlarını içerir.

Uygulamada, kısa vadeli bellek çoğunlukla değişkenler veya listelerde saklanarak, her döngüde prompt içerisine eklenir. Örneğin, LangChain’in kullandığı Conversation Buffer Memory, konuşmadaki tüm mesajları liste olarak tutar. Yine LangChain tarafından sunulan Conversation Buffe Window Memory ise sadece son birkaç mesajı tutarak, LLM’in token sınırını aşmadan güncel bağlamı korumasına yardımcı olur. STM, geçici nitelikte bir bellektir; yani konuşma veya görev tamamlandığında, bellekte tutulan bilgiler genellikle silinir ya da harici bir depolamaya aktarılmadığı sürece kaybolur.

Uzun Vadeli Bellek (Long-Term Memory – LTM)

Uzun vadeli bellek, mevcut bağlam penceresinin dışında veya farklı sohbet oturumları arasında muhafaza edilmesi gereken bilgileri kapsar. Uzun vadeli bellek; ajanın öğrendiği gerçekleri, kullanıcı profili bilgilerini ya da ajanın gelecekteki kararlarını etkileyebilecek önceki deneyimlerini içerebilir.

Uzun vadeli belleğin uygulanması için harici bir depolama gereklidir, çünkü LLM’lerin kendi iç bağlam pencereleri sınırlıdır. Bunun için sık kullanılan yöntemler arasında veritabanları ve vektör veritabanları bulunur. Örneğin LangChain ve LangGraph, uzun vadeli bilgileri saklamak için vektör veritabanlarıyla entegre çalışabilir. CrewAI ise kalıcı bellek için disk üzerinde SQLite gibi basit bir veritabanı kullanır. Uzun vadeli bellek genellikle bilgiye erişim (retrieval) yöntemiyle çalışır: Ajan ihtiyaç duyduğu anda bellekte arama yapar, elde ettiği bilgileri tekrar kısa vadeli bağlamına ekler. Bu açıdan bakıldığında uzun vadeli bellek, ajanın zihninde tutabileceğinden daha fazlasını hatırlamasına imkan tanıyan bir bellek genişletme sistemi gibidir.

Her İki Belleğe Neden İhtiyaç Var?

Kısa vadeli bellek, ajanın mevcut durumu ve görevi hakkında bilgi sahibi olmasını sağlar. Bu olmazsa, ajan kısa süre içinde bağlamdan kopar ve tutarlı cevaplar veremez. Uzun vadeli bellek ise ajanın uzun vadede edindiği bilgileri saklar ve gelecekte kullanmasını mümkün kılar. Bu iki bellek türü, birbirlerini tamamlayıcıdır: kısa vadeli bellek, ajanın mevcut konuşma veya görev adımlarına odaklanmasını sağlarken, uzun vadeli bellek, ajanın önemli gerçekleri ve olayları unutmamasını garanti eder. Eğer bunlardan biri eksik veya yetersiz olursa, ajanın performansı olumsuz etkilenir. Örneğin, uzun bir dokümandan sorulara cevap vermek üzere tasarlanmış bir ajan düşünelim: Uzun vadeli belleği yoksa, bağlam penceresi ilerledikçe önceki kısımları hatırlayamaz. Kısa vadeli belleği yoksa da birkaç mesaj sonrası bile tutarsızlaşabilir.

Pratikte STM ve LTM Kullanımı

Pratikte, mevcut LLM ajanlarının kısa vadeli bellekleri, genellikle kullandıkları modelin token sınırları ile kısıtlıdır. Konuşma veya mantıksal akış bu sınırları aştığında, geliştiriciler hangi bilgilerin tutulup hangilerinin bırakılacağına karar vermelidirler. Bu durumda, pencereli bağlam (windowed context) veya özetleme (summarization) gibi yöntemlere başvurulabilir. Uzun vadeli bellekte ise, depolama açısından bir limit yoktur fakat büyük hacimdeki verilerden doğru bilgiyi verimli şekilde çekebilmek asıl zorluktur. Bu noktada da anlam-temelli arama (semantic retrieval) yöntemleri, özellikle embedding tabanlı aramalar devreye girerek doğru bilgiyi hızlıca bulmayı mümkün kılar.

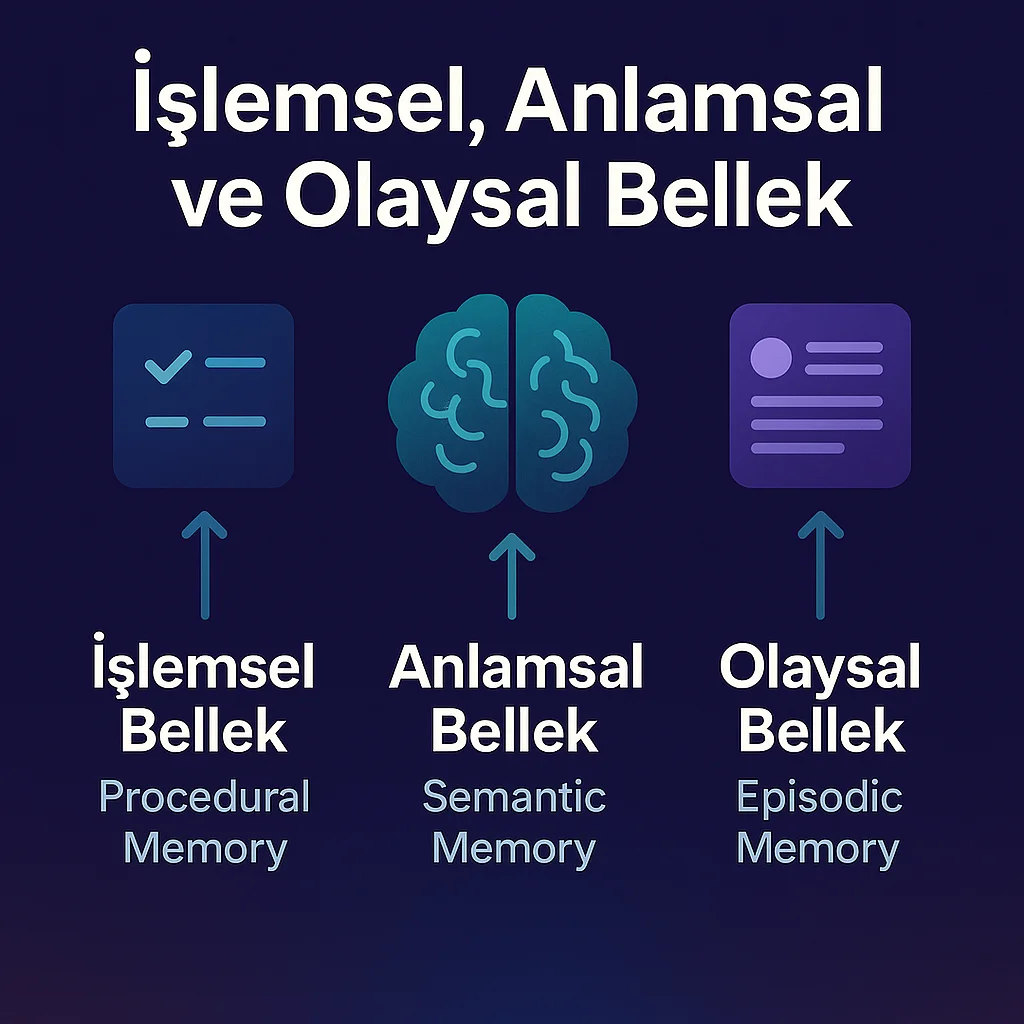

İşlemsel, Anlamsal ve Olaysal Bellek

İnsan belleğinden ilham alarak yapılan çalışmalar, belleği genellikle işlemsel, anlamsal ve olaysal olmak üzere üç kategoriye ayırır. Bu kavramlar, LLM tabanlı ajanlarda farklı bellek modülleri tasarlamak için kullanılabilir.

Olaysal Bellek (Episodic Memory)

Geçmiş deneyimlerin ve yaşanan bölümlerin belleğidir. İnsanlarda belirli bir olayı tüm detaylarıyla hatırlama yeteneği olarak tanımlanır. LLM ajanları için olaysal bellek, ajanın geçmiş etkileşimlerinin tarihçesi anlamına gelir.

Örneğin bir sohbet ajanı, bir kullanıcıyla geçen önceki konuşmalarını veya bir görev çözme sürecinde izlediği adımları olaysal bellek olarak saklayabilir. Bu sayede bağlam sürekliliği sağlanır: Ajan, önceki oturumlardaki kullanıcı sorularını veya yanıtlarını hatırlayarak daha akıcı ve ilgili diyaloglar kurabilir. Olaysal bellek genellikle kısa vadeli bellek ile iç içe düşünülür; pratikte birkaç örnek diyaloğun yeniden sağlanması (few-shot prompting) veya geçmiş mesajların özetlenerek sisteme verilmesi şeklinde uygulanır. Eğer ajan belirli bir dizi adımı doğru şekilde tekrar etmeliyse, geçmiş başarılı adımlar dizisi ona örnek teşkil edebilir – bu yönüyle olaysal bellek, ajan davranışını yönlendirmek için kullanılır.

Anlamsal Bellek (Semantic Memory)

Semantik bellek; gerçekleri, kavramları ve dünya hakkındaki genel bilgileri içeren bellek türüdür. İnsan hafızasında okulda öğrenilen bilgiler, kavramlar arası ilişkiler bu kapsamdadır. Bir LLM ajanında ise anlamsal bellek, dış bilgi deposunda tutulan olgusal veriler olarak düşünülebilir – örnek olarak bir bilgi grafiği veya vektör veritabanında saklanan gerçekler, tanımlar, kavramlar verilebilir. LLM ajanlarında semantik bellek iki şekilde düşünülebilir:

- İçsel semantik bellek: LLM’nin ön eğitim sırasında öğrendiği, kendi ağırlıklarında saklı bilgilerdir.

- Dışsal semantik bellek: Güncel veya detaylı bilgiler için sorgulanabilen harici bir bilgi tabanıdır.

Kişiselleştirme için semantik bellek, kullanıcıyla ilgili bilgileri (isim, tercihler gibi) zaman içinde elde edip depolayabilir. Uygulamada semantik bellek çoğunlukla yapılandırılmış gerçekler biçiminde tutulur; örneğin bir anahtar-değer deposu ({“user_name”: “Alice”, “birthday”: “1 Ocak”}) veya gömme (embedding) yöntemiyle benzerlik sorguları yapılabilen vektör veritabanları olarak saklanır. Ajan çalıştırıldığında, ilgili semantik bilgiyi çekip sistem istemi (prompt) veya bağlamına ekleyebilir. Semantik bellek uzun vadeli ve kalıcıdır. Birçok framework, bu tür bellek kullanımını RAG yöntemiyle uygulamaktadır. Temelde RAG, tüm bilgi tabanını semantik bellek olarak ele alır ve gerektiğinde buradan veri çeker.

İşlemsel Bellek (Procedural Memory)

İşlemsel bellek, bir işi nasıl yapacağımızı, beceri veya prosedürleri hatırlamamızdır. İnsanlarda bu tür bellek “bilmenin ötesinde yapabilme” yeteneğiyle ilişkilidir; örneğin bisiklet sürmek zamanla otomatik hale gelir. LLM ajanlarında işlemsel bellek, ajanın görevleri yerine getirmek için takip ettiği kurallar, politikalar veya süreçleri içerir. Daha soyut bir açıdan bakıldığında, LLM’nin kendi ağırlıkları ve zincir-düşünce (chain-of-thought) örnekleri veya ajan kodları, işlemsel bilgiyi oluşturur.

Bir analiz, Transformer modellerinin öğrendiği dikkat mekanizmalarını (attention patterns) bir tür prosedürel bellek olarak tanımlar; çünkü model, eğitim sırasında gördüğü örüntülere göre bir sonraki tokeni nasıl üreteceğini öğrenir. Daha somut olarak, sistem istemleri (system prompts) ve ajan kodları doğrudan ajanın işlemsel belleğini oluşturur. Örneğin, bir ajanın sistem isteminde “Kullanıcı hava durumunu sorarsa önce Hava Durumu API’sini çağır, sonra sonucu bir cümle halinde formatla” şeklinde bir talimat bulunabilir. Bu talimat prosedürel bilgi örneğidir.

Olaysal ve semantik belleğe kıyasla işlemsel belleğin çalışma sırasında değiştirilmesi daha zordur; genellikle ajanın tasarımında sabitlenmiştir. Özetle, prosedürel bellek, genellikle LLM yetenekleri ile ajanın programlanmış mantığının birleşimidir ve bu belleğin değiştirilmesi, model güncellemesi veya istem değişikliği gerektirir.

Anlamsal Bellek (Semantic Memory)

Semantik bellek; gerçekleri, kavramları ve dünya hakkındaki genel bilgileri içeren bellek türüdür. İnsan hafızasında okulda öğrenilen bilgiler, kavramlar arası ilişkiler bu kapsamdadır. Bir LLM ajanında ise anlamsal bellek, dış bilgi deposunda tutulan olgusal veriler olarak düşünülebilir – örnek olarak bir bilgi grafiği veya vektör veritabanında saklanan gerçekler, tanımlar, kavramlar verilebilir. LLM ajanlarında semantik bellek iki şekilde düşünülebilir:

- İçsel semantik bellek: LLM’nin ön eğitim sırasında öğrendiği, kendi ağırlıklarında saklı bilgilerdir.

- Dışsal semantik bellek: Güncel veya detaylı bilgiler için sorgulanabilen harici bir bilgi tabanıdır.

Kişiselleştirme için semantik bellek, kullanıcıyla ilgili bilgileri (isim, tercihler gibi) zaman içinde elde edip depolayabilir. Uygulamada semantik bellek çoğunlukla yapılandırılmış gerçekler biçiminde tutulur; örneğin bir anahtar-değer deposu ({“user_name”: “Alice”, “birthday”: “1 Ocak”}) veya gömme (embedding) yöntemiyle benzerlik sorguları yapılabilen vektör veritabanları olarak saklanır. Ajan çalıştırıldığında, ilgili semantik bilgiyi çekip sistem istemi (prompt) veya bağlamına ekleyebilir. Semantik bellek uzun vadeli ve kalıcıdır. Birçok framework, bu tür bellek kullanımını RAG yöntemiyle uygulamaktadır. Temelde RAG, tüm bilgi tabanını semantik bellek olarak ele alır ve gerektiğinde buradan veri çeker.

İşlemsel Bellek (Procedural Memory)

İşlemsel bellek, bir işi nasıl yapacağımızı, beceri veya prosedürleri hatırlamamızdır. İnsanlarda bu tür bellek “bilmenin ötesinde yapabilme” yeteneğiyle ilişkilidir; örneğin bisiklet sürmek zamanla otomatik hale gelir. LLM ajanlarında işlemsel bellek, ajanın görevleri yerine getirmek için takip ettiği kurallar, politikalar veya süreçleri içerir. Daha soyut bir açıdan bakıldığında, LLM’nin kendi ağırlıkları ve zincir-düşünce (chain-of-thought) örnekleri veya ajan kodları, işlemsel bilgiyi oluşturur.

Bir analiz, Transformer modellerinin öğrendiği dikkat mekanizmalarını (attention patterns) bir tür prosedürel bellek olarak tanımlar; çünkü model, eğitim sırasında gördüğü örüntülere göre bir sonraki tokeni nasıl üreteceğini öğrenir. Daha somut olarak, sistem istemleri (system prompts) ve ajan kodları doğrudan ajanın işlemsel belleğini oluşturur. Örneğin, bir ajanın sistem isteminde “Kullanıcı hava durumunu sorarsa önce Hava Durumu API’sini çağır, sonra sonucu bir cümle halinde formatla” şeklinde bir talimat bulunabilir. Bu talimat prosedürel bilgi örneğidir.

Olaysal ve semantik belleğe kıyasla işlemsel belleğin çalışma sırasında değiştirilmesi daha zordur; genellikle ajanın tasarımında sabitlenmiştir. Özetle, prosedürel bellek, genellikle LLM yetenekleri ile ajanın programlanmış mantığının birleşimidir ve bu belleğin değiştirilmesi, model güncellemesi veya istem değişikliği gerektirir.

LLM Ajanlarında Bellek Mimarisi ve Teknikleri

Kısa Süreli Bellek Teknikleri

Konuşma Arabellekleri (Conversation Buffers)

Belleğin en basit biçimi, son mesajları veya etkileşimleri tutan bir arabellek (buffer) kullanmak ve bunları sürekli LLM’e geri beslemektir. Bu yaklaşım, LLM’in mesaj dizilerini işleme ve bağlamı sürdürme yeteneğinden doğrudan faydalanır. Konuşma ajanlarının çoğu, varsayılan olarak bu yaklaşımı kullanmaktadır.

Tam Konuşma Arabelleği (Full Conversation Buffer)

Bu yöntem, diyaloğun başından itibaren tüm konuşma geçmişini kaydeder ve her yeni sorgunun başına ekler. Örneğin, LangChain kütüphanesinde bulunan ConversationBufferMemory bu prensiple çalışır ve tüm mesajları sırasıyla tutar. Böylece model, geçmişte söylenenleri her zaman hatırlar. Bu yaklaşımın temel dezavantajı ise token maliyetidir: sohbet uzadıkça sürekli büyüyen bir geçmişi tekrar tekrar modele göndermek gerekir. Bu durum, modelin token sınırlarını aşabilir ve gecikme ile maliyeti artırabilir. Ayrıca çok uzun diyaloglar için ölçeklenebilir değildir; 100 sayfalık bir sohbet geçmişini sürekli 4K tokenlik bir bağlama sığdırmak mümkün olmayacaktır.

Pencereli Arabellek (Windowed Buffer)

Bu yaklaşımda yalnızca son N mesaj tutulur. LangChain’in ConversationBufferWindowMemory modülü buna iyi bir örnektir. Örneğin, pencere boyutu 5 ise yalnızca son 5 mesaj çiftini hatırlar, daha eski mesajlar atılır. Bu yöntem, belleğin boyutunu ve maliyetini sınırlarken eski bağlamın kaybedilmesi dezavantajını taşır. Eski konuların tekrar gündeme gelme olasılığının düşük olduğu durumlarda etkili çalışır, ancak eski konular tekrar ortaya çıkarsa önemli detaylar unutulabilir.

Token Sınırlamalı Arabellek (Token-Limited Buffer)

Bazı uygulamalar, sabit mesaj sayısı yerine toplam token sayısını sınırlayarak bellek kullanımını yönetir. LangChain’deki ConversationTokenBufferMemory, toplam token sayısının belirli bir eşiği aşmasını engellemek için, gerektiğinde en eski mesajları atarak belleği kontrol eder. Bu yöntem, bir mesajın çok fazla token harcaması durumunda daha esnek davranabilir.

Yapılandırılmış Mesaj Geçmişi (Structured Message History)

Ajanlar genellikle geçmiş mesajlarda kimin ne söylediğini açıkça belirtir (“Kullanıcı: …”, “Asistan: …” gibi). Bu, LLM’in kendi mesajlarını kullanıcı girdilerinden ayırt etmesini kolaylaştırır. Ayrıca bazı sistemler, araç çıktıları veya özel notlar gibi diğer olayları da bu geçmişe dahil edebilir. Örneğin, bir ajan, geçmişte bir web arama sonucunu şu şekilde tutabilir: “Araç çıktısı: [web arama sonucu]”. Bu tür bilgilerin doğru formatlanması ve tampon içinde tutulması, iyi bir ajan tasarımının önemli parçalarından biridir.

Avantajlar ve Dezavantajlar

Konuşma arabellekleri basit ve doğrudan uygulanabilir olup, LLM’in ardışık bağlamı işleyebilme yeteneğinden faydalanır. Özellikle kısa sohbetlerde çok etkili olup, tutarlı ve çoklu tur içeren diyaloglar için temel yöntem olarak kullanılırlar. Ancak bu yöntem gerçek anlamda uzun vadeli bilgi tutma sorununu çözmez. Nihayetinde arabellek dolacak veya kısaltılacak, bu da ajanın eski bilgileri unutmasına yol açacaktır. Ayrıca, sürekli büyüyen geçmiş mesajlar belirli bir noktadan sonra faydalı bilgiden çok gereksiz yere token tüketimine yol açabilir. Bu nedenle geliştiriciler, arabellekleri genellikle özetleme veya harici bellek sistemleri gibi diğer yöntemlerle birleştirerek kullanırlar.

Uzun Süreli Bellek Teknikleri

Özetleme ve Periyodik Bellek Sıkıştırma

Sürekli büyüyen sohbet geçmişinin yarattığı problemi çözmek için kullanılan popüler yöntemlerden biri eski etkileşimleri özetlemektir. Bu yöntemin temel fikri, önceki konuşmalardan veya görev adımlarından önemli bilgileri daha kısa bir özet haline getirerek, tam metin yerine bu özeti bağlama eklemektir. Bu sayede modele, olaysal bellek özeti sağlanmış olur.

Örneğin, bir yapay zeka ajanının kullanıcı ile 50 mesajlık uzun bir sohbet yaptığını düşünelim. 51. mesaja geldiğinde tüm bu geçmiş mesajları modele tekrar göndermek mümkün olmayabilir. Bu durumda ajan sohbeti özetleyen bir metin üretebilir.

Bu özet, tam sohbet geçmişinden çok daha kısadır ama kritik detayları korur. Bundan sonraki adımlarda ajan, bağlamı sürdürmek için yalnızca bu özet ve son birkaç mesajı kullanarak hareket edebilir.

LangChain, bu yöntemi uygulamak için ConversationSummaryMemory modülünü sunar. Bu modül, LLM yardımıyla sohbetin devam eden bir özetini oluşturur. Her yeni mesaj geldiğinde bu özeti günceller. Özetin kendisi, sohbet içinde uzun vadeli bellek gibi davranır.

Avantajlar

- Özetleme, önemli bilgileri korurken token kullanımını ciddi şekilde azaltır.

- Neredeyse sınırsız uzunlukta sohbetleri mümkün kılar; diyalog ilerledikçe sürekli yeni özetler oluşturarak devam etmek mümkündür.

- Önemsiz veya tekrar eden detayları filtreleyerek daha temiz bir bellek sunar.

Dezavantajlar

- Özetin kalitesi kritiktir. Hatalı bir özet, kritik bilgileri atlayabilir ya da yanlış bilgiler içerebilir.

- Özet üretmek için yapılan ek LLM çağrıları nedeniyle maliyet ve işlem yükü artabilir.

Bu dezavantajlara rağmen, uzun diyaloglarda veya çok aşamalı işlemlerde olaysal bellek yönetimi için özetleme çok kullanışlı ve etkili bir yöntemdir.

Hibrit Bellek Modelleri

Hibrit yaklaşımlar, birden fazla bellek mekanizmasını birleştirerek her birinin güçlü yönlerinden faydalanmayı hedefler. Bu modeller, bellek yönetiminin karmaşıklığını azaltır ve daha etkin sonuçlar üretir.

Parametrik ve Parametre dışı bellek:

Fine-tune edilmiş LLM’lerin yanında, dinamik bilgi erişimi sağlayan harici bellek sistemlerini kullanarak hem kalıcı bilgi hem de güncel içeriklere erişim sağlanır. Ajan düzeyinde düşünürsek, bir ajan hem fine-tuning ile belirli bir bilgiye doğrudan sahip olabilir, hem de ihtiyaç duyduğunda dış bir veri tabanını sorgulayarak daha spesifik içeriklere erişebilir.

Sembolik + Nöral bellek:

Ajan, yapılandırılmış bilgiler (örneğin: ad, yaş gibi form verileri) için sembolik belleği; yapılandırılmamış konuşmalar ve uzun metinler için ise vektör temelli belleği kullanabilir. Bu yaklaşım özellikle kullanıcı profili + sohbet geçmişi ayrımında işe yarar.

Özetleme + Vektör belleği:

Her günün sonunda yapılan sohbeti özetleyip bu özetleri vektör veritabanında saklamak, ham veriler yerine kısa ve anlamlı özetlerin alınmasını sağlar. Bu, uzun geçmişlerin daha yönetilebilir hale getirilmesini sağlar.

Herhangi bir kombinasyon, bellekle ilgili belirli bir sorunu çözüyorsa geçerlidir. Geliştiriciler genellikle bu konuda oldukça yaratıcı çözümler geliştirir. Örneğin; önemli gerçekleri hassas sorgular için bir bilgi grafiğinde, genel etkileşimleri ise vektör bellekte tutabilirsiniz. Ajan bir soruyla karşılaştığında önce bilgi grafiğini, ardından bağlamsal bilgi için vektör belleği tarayabilir.

Çoklu LLM kullanımıyla hibrit model

Gelişmekte olan başka bir hibrit yaklaşım ise birden fazla LLM kullanmaktır. Örneğin, küçük bir model sürekli sohbeti takip edip önemli noktaları özetlerken, daha büyük bir model aktif sohbeti yürütür. Bu iş bölümü sistemin verimliliğini artırır. Küçük model arka planda belleği günceller – adeta bir bilinçaltı gibi davranır. Microsoft’un AutoGen framework’ü bu tür çoklu ajanlı yapıları desteklemektedir.

Uygulama Senaryoları

Teknik açıdan bakıldığında, ideal bellek entegrasyon çözümü, projenin bağlamına ve gereksinimlerine bağlıdır. Örneğin:

- Kurumsal Bilgi Tabanları: RAG tabanlı ajanlar

- Kişiselleştirilmiş Asistanlar: Hibrit sistemler

- Uzun Süreli Etkileşimli Uygulamalar: Özetleme destekli uzun vadeli bellek modelleri.

Hibrit sistemlerin yükselişi, farklı tekniklerin güçlü yanlarını birleştirerek, LLM ajanlarının bellek yönetimi konusunda daha akıllı, verimli ve kullanıcı odaklı çözümler sunmasını sağlıyor. Bu eğilim, yapay zeka sistemlerinin geleceğinde bellek yönetiminin önemini giderek artırarak devam edecektir.

Daha Fazlasını Öğrenin

Sizin Gibi Çalışan Yapay Zeka (AI) Çalışanları İçin Şimdi Demo İsteyin

Ücretsiz Demonuza Erişmek İçin İletişime Geçin