11.07.2025

Büyük Veri Setlerinde Vektör Arama Nasıl Optimize Edilir?

Büyük veri setlerinde vektör aramayı hızlandırmak ve optimize etmek mi istiyorsunuz? Veri hazırlama, algoritma seçimi ve altyapı iyileştirmeleriyle milisaniyelerde sonuç alın! Performansınızı artıracak en güncel teknikleri bu rehberde keşfedin.

Navigation

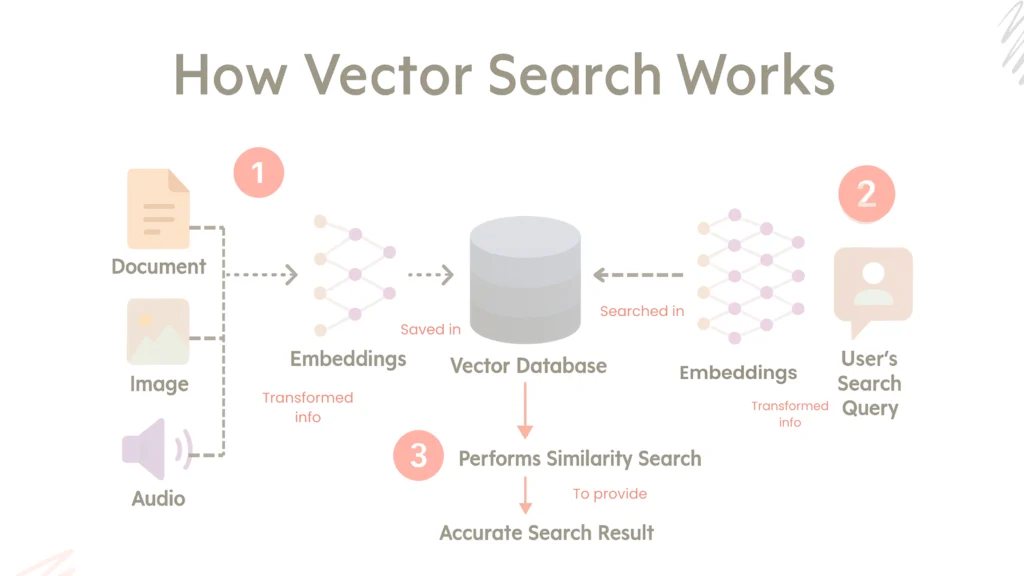

Vektör arama sistemleri, yapay zeka ve makine öğrenmesi temelli birçok uygulamanın temelini oluşturur. Özellikle öneri sistemleri, semantik arama, görsel tanıma gibi alanlarda, içerikler yüksek boyutlu vektörlere dönüştürülerek indekslenir ve benzerlik temelli karşılaştırmalar yapılır. Ancak veri boyutu büyüdükçe bu süreç hem hesaplama açısından zorlu hale gelir hem de donanımsal kaynak ihtiyacı artar.

Bu nedenle, vektör aramayı optimize etmek için aşağıdaki üç katmanlı yaklaşım izlenmelidir:

1- Vektör Verisinin Etkili Hazırlanması

Veri kalitesi doğrudan arama sonuçlarını etkiler. İyi yapılandırılmış vektör verisi hem daha doğru sonuçlar sağlar hem de sistem kaynaklarını daha verimli kullanır.

Normalizasyon

Sorun

Farklı büyüklükteki vektörler, özellikle cosine similarity gibi benzerlik ölçütleriyle kıyaslandığında anlamlı sonuçlar üretmez. Ölçeksiz veriler tutarsız benzerlik skorlarına neden olabilir.

Yöntemler

● L2 Normalizasyon: Her vektör, kendi L2 normuna bölünerek birim uzunluğa getirilir. Bu işlem sayesinde tüm vektörler aynı ölçeğe sahip olur ve özellikle cosine similarity hesaplamalarında tutarlılık sağlanır.

● Min-Max Normalizasyon: Veri bileşenleri, belirli bir aralığa (genellikle 0 ile 1 arasında) ölçeklendirilir. Bu yöntem, farklı ölçeklerdeki değerleri standartlaştırmak için kullanılır.

● Z-Score Normalizasyon (Standardizasyon): Veri bileşenlerinden ortalama çıkarılır ve standart sapmaya bölünür. Sonuç olarak veriler ortalaması 0, standart sapması 1 olan bir dağılıma getirilir. Özellikle istatistiksel modellere ön hazırlık için uygundur.

● Batch Normalization: Bir sinir ağı katmanındaki aktivasyonlar, mini-batch içinde ortalama ve varyans bazında normalize edilir. Bu sayede eğitim süreci hızlanır ve kararlılık artar.

Boyut Azaltma

Sorun

Yüksek boyutlu vektörler (örn. 1024 boyut), daha fazla hesaplama ve daha fazla

bellek gerektirir.

Yöntemler

● PCA (Principal Component Analysis): PCA, istatistiksel temelli bir boyut indirgeme tekniğidir ve temel amacı, yüksek boyutlu verilerdeki değişkenliği (varyansı) en iyi açıklayan yeni boyutlar (principal components) elde etmektir. Bu yöntem, verinin en fazla bilgi (yani varyans) taşıyan eksenlerini bulur ve yalnızca bu eksenler doğrultusunda yeni bir alt uzay oluşturur. Bu sayede, verideki temel yapılar korunurken, bilgi açısından daha az katkı sağlayan boyutlar elenir. Böylece hem hesaplama maliyeti düşer hem de gürültü azalır.

● Autoencoder: Autoencoder mimarisi, yüksek boyutlu verilerin daha kompakt ve anlamlı temsillere indirgenmesini sağlayan, denetimsiz öğrenmeye dayalı bir yapay sinir ağıdır. Temelde iki bileşenden oluşur: encoder ve decoder. Encoder, girdi veriyi alarak daha düşük boyutlu bir temsile — yani latent space’e — sıkıştırır. Decoder ise bu düşük boyutlu temsili kullanarak orijinal veriyi yeniden oluşturmaya çalışır. Bu yapı sayesinde model, verinin taşıdığı temel özellikleri öğrenir; dolayısıyla encoder çıktısı, bilginin özetlenmiş ancak anlam açısından zengin bir temsilidir. Bu yaklaşım, yüksek boyutlu embedding’lerin vektör tabanlı veri tabanlarına (örneğin Qdrant) daha verimli şekilde aktarılması için oldukça etkilidir. Özellikle dil modelleriyle elde edilen embedding’ler çoğunlukla 768 veya daha fazla boyut içerir. Bu boyuttaki vektörleri doğrudan vektör veritabanına kaydetmek, hem depolama açısından maliyetlidir hem de benzerlik arama işlemlerinde performans kaybına yol açabilir.

Projemizde bu problemi çözmek için, embedding’ler öncelikle bir autoencoder’ın encoder bileşeni aracılığıyla daha düşük boyutlu bir temsile dönüştürülmektedir. Örneğin, başlangıçta 768 boyutlu olan bir embedding, encoder tarafından 128 boyutlu bir latent vektöre indirgenmektedir. Bu daha küçük ama anlamlı vektör, vektör veritabanı olan Qdrant’a eklenmek üzere kullanılır.

Avantaj: Hesaplama maliyeti azalır, sorgular hızlanır, indeks boyutu düşer.

Kuantizasyon

Sorun

Vektörler varsayılan olarak 32-bit float olarak saklanır, bu da büyük bellek ve disk

kullanımı anlamına gelir.

Yöntemler

● 8-bit Quantization: Vektördeki her bileşen, varsayılan 32-bit float yerine 8-bit tam sayı ile temsil edilir.

Böylece veri boyutu yaklaşık dörtte bire düşer ve hem depolama hem de hesaplama maliyeti önemli ölçüde azalır.

● 16-bit Float (Float16) Quantization: Veriler 32-bit kayan nokta yerine 16-bit kayan nokta formatında saklanır. Bu, veri boyutunu yarı yarıya düşürürken, kayan noktanın sağladığı esnek aralık sayesinde doğruluk büyük ölçüde korunur.

● Bfloat16 Quantization: 16-bit kayan nokta formatının bir çeşididir ve 8-bit üs kısmı sayesinde daha geniş bir değer aralığı sunar. Bu format, özellikle derin öğrenme modellerinde hesaplama hızını artırırken, doğruluk kaybını minimize eder.

● Int16 Quantization: Her vektör bileşeni 16-bit işaretli tam sayı olarak kodlanır. Bu, 32-bit float’a kıyasla veri boyutunu yarı yarıya küçültür ve aritmetik işlemler genellikle 32-bit tam sayılarla yapılır.

● Product Quantization (PQ):

○ Vektör segmentlere ayrılır (örneğin 128 boyutlu bir vektör, 8 segment × 16 boyut).

○ Her segment kendi kodbook’u ile sıkıştırılır.

○ Böylece hem bellekte büyük tasarruf sağlanır hem de benzerlik karşılaştırmaları kodlar üzerinden çok daha hızlı yapılır.

Avantajlar:

● %70–90 oranında depolama tasarrufu

● Daha küçük indeks boyutu

● Önemli ölçüde hızlanan arama performansı

2- Doğru Algoritmaların Kullanımı

Yaklaşık En Yakın Komşu (Approximate Nearest Neighbor - ANN) Algoritmaları

Tüm vektörlerle doğrudan karşılaştırma yapmak (brute-force) büyük veri setlerinde pratik değildir. Bu nedenle küçük doğruluk kayıplarıyla çok büyük hız kazancı sağlayan ANN algoritmaları tercih edilir. ANN algoritmalarının çeşitli varyasyonları vardır:

Varyasyon 1-IVF (Inverted File Index)

Yapı

IVF, vektörleri önceden belirlenmiş sayıda merkez etrafında kümelere ayırarak indeksleyen bir kümeleme tabanlı yapı sunar. Her bir küme, o kümeye en yakın vektörlerin yer aldığı bir liste (posting list) içerir. Bu yapı sayesinde IVF, vektörleri daha düzenli ve erişilebilir bir şekilde organize eder, böylece sorgu işlemleri daha verimli hale gelir.

Çalışma Prensibi

İlk adımda, k-means gibi bir kümeleme algoritması ile tüm vektör uzayı k sayıda kümeye ayrılır. Her vektör, en yakın merkez (centroid) ile eşleştirilerek ilgili listeye atanır. Sorgulama aşamasında, arama yalnızca sorgu vektörüne en yakın nprobe kadar küme üzerinde yapılır. Böylece, tüm veri üzerinde arama yapmak yerine yalnızca ilgili bölümlerde yoğunlaşılır; bu da performansı büyük ölçüde artırır.

Parametreler

● k: Küme sayısı – detay seviyesi ve indeks hassasiyetini belirler.

● nprobe: Sorgu sırasında kaç kümenin dikkate alınacağı – daha yüksek değerler daha doğru sonuç verir ancak işlem süresini uzatır.

● PQ (Product Quantization): IVF’in bellekte daha az yer kaplaması için sıkıştırma opsiyonu olarak kullanılabilir.

Avantajlar

● Yüksek Ölçeklenebilirlik: Milyarlarca vektörü işleyecek kapasiteye sahiptir.

● Disk Üzerinde Çalışabilme: Belleğe sığmayan veri kümeleri için idealdir.

● Performans Odaklı: Özellikle değişmeyen veri setlerinde çok verimli çalışır.

● FAISS ile Entegrasyon: Facebook tarafından geliştirilen FAISS, IVF’in yüksek verimle kullanılmasını sağlar.

Kullanım Alanları

● Görsel benzerlik aramaları

● Tavsiye motorları

● Büyük hacimli vektör tabanlı yapay zeka sistemleri

Kısıtlar

● Dinamik veri desteği sınırlıdır; yeni veri eklemek genellikle yeniden kümelemeyi

gerektirir.

● Kümeleme kalitesi arama başarımını doğrudan etkiler.

● Yanlış tanımlanmış kümeler, bazı yakın sonuçların gözden kaçmasına neden

olabilir.

Varyasyon 2- HNSW (Hierarchical Navigable Small World)

Yapı

HNSW, vektörleri çok katmanlı bir küçük-dünya grafı (small-world graph) biçiminde organize eder. Her vektör, belirli sayıda komşu ile bağlantılı bir düğüm olarak yer alır. Üst katmanlarda daha seyrek ama uzun menzilli bağlantılar bulunurken, alt katmanlar daha sıkı ve lokal bağlantılarla daha detaylı aramalar yapılmasına olanak tanır.

Çalışma Prensibi

Arama, en üst katmandan başlanarak yapılır. Sorgu vektörüne en yakın düğüm arandıktan sonra, daha alt katmanlara inilerek daha hassas tarama gerçekleştirilir. En alt katmanda, efSearch kadar aday düğüm incelenerek en benzer sonuçlar tespit edilir. Bu çok katmanlı yapı, hem genel hem de lokal düzeyde hızlı ve doğru arama sağlar.

Parametreler

● M: Her düğümün bağlandığı maksimum komşu sayısı. Yapının yoğunluğunu

belirler.

● efConstruction: İndeksleme sırasında dikkate alınacak aday sayısı – daha büyük değer daha iyi yapı ama daha uzun inşa süresi anlamına gelir.

● efSearch: Sorgu sırasında değerlendirilecek düğüm sayısı – doğruluğu ve sorgu süresini doğrudan etkiler.

Avantajlar

● Yüksek doğruluk oranı: Yakınsak olmayan (approximate) olmasına rağmen, çoğu zaman neredeyse birebir sonuç verir.

● Düşük gecikmeli sorgular: Gerçek zamanlı sistemler için idealdir.

● RAM odaklı performans: Bellek içi yüksek hızlı arama uygulamalarında etkilidir.

Kullanım Alanları

● Gerçek zamanlı öneri motorları

● Dinamik içerik akışı sistemleri

● Yüksek doğruluk gerektiren bilgi erişim uygulamaları

Kısıtlar

● Yüksek bellek kullanımı nedeniyle, büyük veri setlerinde sistem kaynakları zorlanabilir.

● İndeksleme süresi uzundur, özellikle yüksek efConstruction değerlerinde.

● Disk tabanlı çalışmalarda verimsizdir; yapı RAM’e bağımlıdır.

Varyasyon 3- ANNOY (Approximate Nearest Neighbors Oh Yeah)

Yapı

ANNOY, vektörleri çok sayıda rastgele projeksiyona dayalı ikili ağaç yapılarında depolar. Her ağaç, vektörleri rastgele belirlenmiş düzlemlere göre ikiye böler ve bu işlem yapraklara ulaşılana kadar devam eder. Ağaçlar disk üzerinde saklanabilir ve mmap (memory-mapped file) ile birden çok süreç tarafından ortak kullanılabilir.

Çalışma Prensibi

İndeksleme sırasında her ağaç, vektörleri rastgele seçilmiş bir düzleme göre iki alt gruba ayırarak ayrıştırır. Bu işlem tekrarlanarak ağaç yapısı tamamlanır. Arama işlemi sırasında birden fazla ağaç taranır ve search_k kadar düğüm değerlendirilir. Daha fazla ağaç ve aday sayısı, doğruluğu artırırken performansa etki edebilir.

Parametreler

● f: Vektör boyutu.

● n_trees: Oluşturulacak ağaç sayısı – doğruluk ve indeks boyutunu etkiler.

● search_k: Sorgu sırasında değerlendirilecek toplam aday sayısı – doğruluk ve hız arasında denge kurar.

Avantajlar

● Disk uyumlu yapı: İndeksler diske kaydedilebilir ve ihtiyaç duyulduğunda bellek haritalama ile hızlıca erişilebilir.

● Düşük bellek gereksinimi: Paylaşımlı kullanım ve belleğe tam yüklenmeden çalışma özelliği sunar.

● Hızlı indeks yükleme: mmap ile indeksler anında erişilebilir hale gelir.

● Sabit veri setleri için ideal: Veri setinin sık değişmediği durumlarda yüksek performans sağlar.

Kullanım Alanları

● Spotify gibi müzik öneri sistemleri

● Embedding arşivleri ve vektör bazlı arama

● Paralel çalışan sistemlerde indeks paylaşımı

Kısıtlar

● Güncelleme desteklemez: Dinamik veri için indeksin baştan inşa edilmesi gerekir.

● Yüksek boyutlu sparse verilerde performans kaybı yaşanabilir.

● HNSW’ye kıyasla doğruluk genellikle daha düşüktür.

Diğer Alternatifler

● ScaNN (Google): Yüksek doğruluk, yeniden sıralama (re-ranking) ve kuantizasyon destekler.

● DiskANN (Microsoft): Disk üzerinde milyarlarca vektörle RAM’e sığmayan verin için etkili.

● NMSLIB: HNSW benzeri yapı, açık kaynak ve performansı yüksek.

3- Altyapı ve Donanımın Optimize Edilmesi

Vektör arama sisteminin hız ve ölçeklenebilirliği yalnızca algoritma ve veriden değil, altyapı kararlarından da etkilenir.

Dağıtık Sistemler ve Sharding

Sorun

Tek bir sunucunun milyarlarca vektörü taşıması mümkün değildir.

Çözüm

Veri kümesi shard’lara (parçalara) bölünerek çoklu sunuculara dağıtılır.

Paralel Sorgulama: Her shard kendi içinde sorguyu işler; sonuçlar merkezi sistemde birleştirilir.

Örnek Platformlar

○ Milvus: GPU destekli, yüksek performanslı vektör veritabanı.

○ Qdrant: Rust tabanlı, hızlı ve JSON filtrelemeyi destekler.

○ Vespa: Vektör arama, filtreleme ve ML skorlama tek çatı altında.

○ Weaviate: Otomatik embedding, semantik arama, GraphQL desteği.

GPU Hızlandırması

● Sorun: CPU ile yapılan aramalar yüksek gecikmeye neden olabilir.

● Çözüm: GPU ile paralel sorgu işleme.

● FAISS-GPU: Facebook tarafından geliştirilen FAISS’in CUDA destekli versiyonu ile milyonlarca vektör milisaniyelerde sorgulanabilir.

Performans İzleme ve İnce Ayar

Metrikler

○ Recall@k: Gerçek doğru sonuç ilk k içinde mi?

○ Latency: Ortalama sorgu süresi.

○ QPS: Saniyede yanıtlanan sorgu sayısı.

○ efSearch, nprobe: Hız/doğruluk arasında denge kurmak için kullanılır. Ayrıca, karma arama yöntemi hem vektör benzerlik araması hem de yapısal filtrelemeyi bir arada kullanarak daha hedefli sonuçlar sunar. Örneğin, “Benzer görselleri getir ancak sadece elektronik kategorisinde ve fiyatı 500 TL’nin altında olanlar” gibi sorgular bu yöntemle kolayca yapılabilir. Vespa, Qdrant ve Weaviate gibi sistemler bu yeteneği destekler; Vespa makine öğrenimi skorlama ile klasik filtrelemeyi, Qdrant JSON tabanlı güçlü filtreleri, Weaviate ise GraphQL ile sade ve esnek karma sorguları sağlar.

Sonuç: Üç Katmanlı Optimizasyon Stratejisi

1. Algoritma Seviyesi: HNSW, IVF gibi yöntemlerle hızlı ve esnek arama.

2. Veri Hazırlık Seviyesi: Normalizasyon, boyut azaltma, kuantizasyon ile verimli

temsil.

3. Altyapı Seviyesi: Sharding, GPU, performans izleme ve karma sorgu desteği. Bu katmanlar birlikte optimize edildiğinde, milyarlarca öğeden oluşan veri setlerinde bile milisaniye mertebesinde, doğru sonuçlara ulaşmak mümkündür.

Daha Fazlasını Öğrenin

Sizin Gibi Çalışan Yapay Zeka (AI) Çalışanları İçin Şimdi Demo İsteyin

Ücretsiz Demonuza Erişmek İçin İletişime Geçin