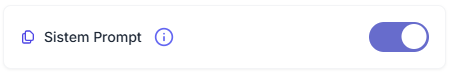

Sistem Prompt

- Etkin (Enabled): Sistem, mevcut sistem prompt, asistan prompt ve mevcut konuşma geçmişi korur. Böylece model, tüm etkileşimi daha kapsamlı anlayarak daha doğru ve bağlama uygun yanıtlar üretir.

- Devre Dışı (Disabled): Sistem, sistem promptu yok sayar ve yalnızca asistan prompt üzerinden yanıt üretir. Bu, bazı özel görevlerde temiz ve bağlamdan bağımsız yanıtlar almak için faydalı olsa da genellikle konuşmanın bütünlüğünü zayıflatır.

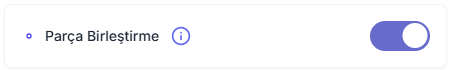

Merge Chunking (Parça Birleştirme)

RAG (Retrieval-Augmented Generation) sistemlerinde, anlam veya konu bakımından ilişkili metin parçalarının birleştirilerek daha büyük bir blok haline getirilmesi işlemidir. Bu sayede model daha bütünlüklü bir bağlam alır ve yanıt kalitesi yükselir.

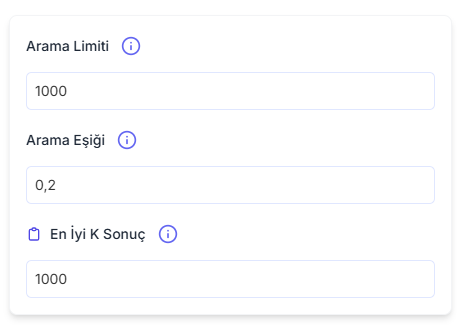

Search Limit (Arama Limiti)

Bir ajanın bilgi kaynağından (ör. vektör veritabanı) sorguya karşılık getirebileceği maksimum sonuç sayısını sınırlar. Daha yüksek bir değer, daha geniş bir bilgi havuzuna erişim sağlayarak kapsamlı yanıtlar üretmeye yardımcı olur.

Tam Kapsama İçin Ayarlama

Örneğin, kullanıcıdan yüklenen bir dosya 100 vektöre bölündüyse, Search Limit’i 100 olarak ayarlamak, tüm parçaların ilk taramada göz önünde bulundurulmasını sağlar. Böylece kritik satırların atlanma riski ortadan kalkar.

Not: Maksimum limit sayısı, knowledge’a belge yüklenip asistan kaydedildikten sonra arama limiti barının üzerinde görüntülenir.

- Top-K ile birlikte çalışır: Search Limit, “hangi havuzdan seçeceğim?”; Top-K ise “bu havuzdan kaçı gerçekten LLM’e gitsin?” sorusunu cevaplar. Ayrıntı kaybı istenmeyen durumlarda her ikisi aynı değerlere çekilebilir (örn. 40-40).

- Yüksek değer = yüksek recall: Derinlerdeki bilgiyi de yakalar, fakat maliyet ve gecikmeyi artırır.

- Düşük değer = Yanıt süresi kısalır, fakat doğru içeriği kaçırma riski artar.

Search Threshold (Arama Eşiği)

Bir bilginin, kullanıcı sorgusuna ne kadar benzemesi gerektiğini belirler. Bu eşik, alakasız sonuçların filtrelenmesini sağlar. Belirlenen skorun altındaki sonuçlar görmezden gelinir.

Teknik Detay ve Pratik İpuçları (İleri Kullanıcılar için):

- Vektör aramada skorlar 0 ile 1 arasında normalize edilir; skor 1’e yaklaştıkça benzerlik artar.

- Düşük eşik → Daha fazla sonuç getirir, ancak alakasız veri oranı artabilir.

- Yüksek eşik → Daha az, ama daha alakalı sonuç getirir; doğru bilgilerin dışarıda kalma riski vardır.

- Pratikte: Reranking (yeniden sıralama) kullanılacaksa, Search Threshold daha düşük ayarlanabilir. Böylece ilk katmanda daha geniş bir havuz çekilir, alakasız olanlar ikinci aşamada elenir.

Top-K (En İyi K Sonuç)

- RAG sistemlerinde, elde edilen geniş sonuç kümesinden en alakalı K adet sonucu seçer.

- Örnek: Bir arama 100 sonuç döndürürse ve Top-K değeri 5 ise, sistem yalnızca en iyi 5 sonucu kullanır.

- Search limit ile farkı: Search limit, ilk etapta kaç sonuç çekileceğini belirlerken; Top-K, bu havuzdan en iyilerini seçer.

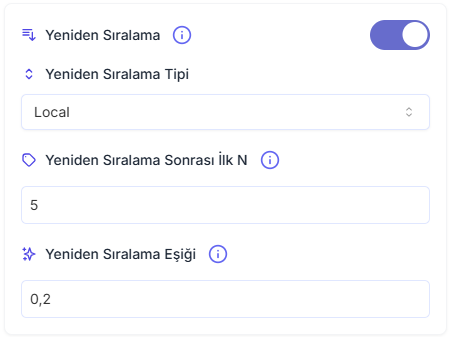

Reranking (Yeniden Sıralama)

- İlk arama sonuçlarının ikinci bir model tarafından yeniden puanlanarak, en alakalı olanların öne çıkarılması sürecidir.

- Etkin (Enabled): Daha doğru sonuçlar için ileri seviye model, belgeleri yeniden sıralar.

- Devre Dışı (Disabled): Bu adım atlanır, daha hızlıdır ancak sonuçların doğruluğu düşebilir.

Rerank Top-N (Yeniden Sıralama Sonrası İlk N)

Reranking işleminden sonra en alakalı N sonuç seçilerek LLM’e gönderilir. Böylece model, yalnızca en faydalı belgelerle çalışır ve gereksiz bilgi yükünden korunur.LLM’in context window’u sınırlıdır (örn. 4K, 8K, 32K token). Fazla belge yüklemek performansı düşürür.

Ayar önerileri:

- Tekil, kesin cevap gereken sorular: N küçük (3-5).

- Karşılaştırma, özetleme, çok perspektifli analiz: N orta-yüksek (10-20).

Pratik İpuçları

- Veri setiniz küçük ve temizse, reranking kapalı da çalışabilir; büyük, heterojen koleksiyonlarda mutlaka açık tutun.

- Kritik doğruluk (medikal, hukuki) => threshold yüksek, Top N düşük.

- Yaratıcı/özetleyici senaryolar => threshold orta, Top N daha yüksek.

Rerank Top-N (Yeniden Sıralama Sonrası İlk N)

Reranking sonrası belgeler için minimum bir skor belirler. Bu eşik değerinin altındaki belgeler elenir, yalnızca en yüksek puanlı içerikler modele aktarılır. Böylece modelin kullandığı bilgi güvenilir ve odaklı kalır.

Yüksek eşik (≥ 0.7): Yalnızca çok ilgili belgeler kalır → yüksek hassasiyet, düşük kapsam.

Düşük eşik (≈ 0.1-0.4): Daha fazla belge kalır → yüksek kapsam, ancak ilgisiz içerik riski.