27.06.2025

vLLM ve LLM Sunumun Yeni Çağı

LLM’lerin sınırlarını zorlayan vLLM ile tanışın! Yeni nesil PagedAttention teknolojisi sayesinde daha hızlı, verimli ve düşük gecikmeli yapay zeka deneyimi sizi bekliyor. RAG sistemlerinden chatbotlara kadar her alanda fark yaratıyor.

Navigation

Geçtiğimiz birkaç yılda ana akım teknolojide ortaya çıkan Büyük Dil Modelleri veya LLM’ler, bilgiye hızlı erişim sağladı ve büyük teknolojik gelişmelerin yolunu açtı. Ortalama bir kullanıcı için LLM’ler verimli görünebilir ancak büyük enerji tüketimiyle gelir ve çok sayıda GPU gerektirir. Büyük miktarda donanımla birlikte, piyasadaki çoğu ürünün kullandığı mevcut mimari nedeniyle isteklerde gecikmeler de gelir. Bu, belleği daha önce görmediğimiz bir şekilde daha verimli bir şekilde işleyecek farklı bir mimari arayışına yol açtı. LLM’lerin hesaplamaları daha verimli bir şekilde gerçekleştirmesini sağlayan vLLM veya Sanal Büyük Dil Modeli devreye giriyor.

vLLM nedir?

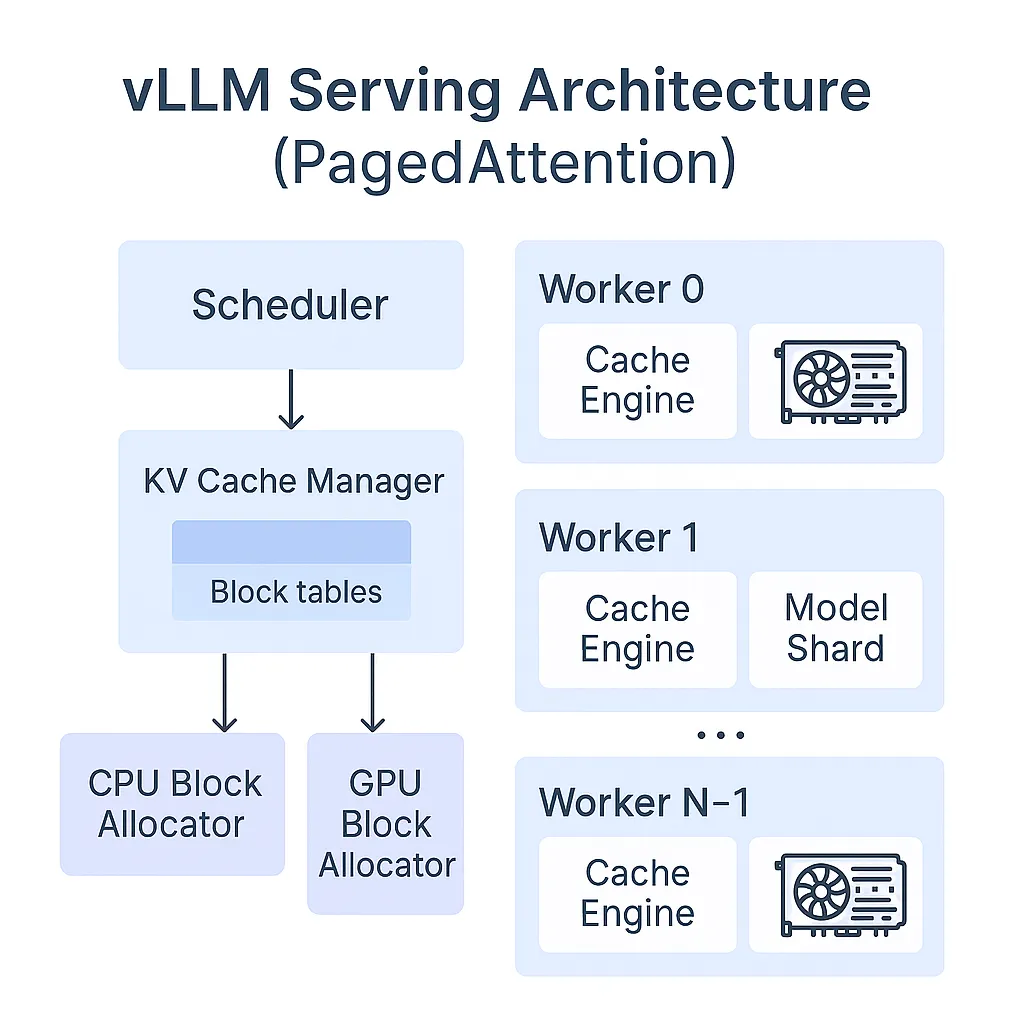

vLLM, GPU belleğini, özellikle dikkat anahtarlarını ve değerlerini daha etkili bir şekilde yöneten PagedAttention’ı kullanan hızlı LLM çıkarımı ve sunumu için açık kaynaklı bir kütüphanedir. İlk olarak UC Berkeley, Stanford Üniversitesi ve UC San Diego’dan araştırmacılar tarafından “PagedAttention ile Büyük Dil Modeli Sunumu için Verimli Bellek Yönetimi” adlı bir makalede tanıtıldı. Makale, mevcut LLM’lerin verimlilik ve ölçeklenebilirlik açısından yaşadığı zorluklar hakkında katkılarda bulunuyor ve bunun yerine GPU’ların nasıl kullanılması gerektiğine dair bir çözüm sunuyor.

vLLM, geleneksel LLM'lerden nasıl farklıdır?

vLLM’lere dalmadan önce, LLM modellerinin ve bellek sistemlerinin bildiğimiz şekilde nasıl çalıştığını anlamak önemlidir. LLM’lerin özünde, girişe (veya istemi) ve bugüne kadar ürettiği çıktı token’larının önceki dizisine dayalı olarak bir seferde bir token üretmek için otomatik gerileyen bir kod çözücü kullanan bir Transformers modeli yer alır. Her istek için token üretimi, model bir sonlandırma token’ı döndürene kadar gerçekleştirilir. Makale, bu dizinin işlemi belleğe bağlı hale getirdiğini, bunun da GPU’ların hesaplama yeteneklerini yetersiz kullandığını ve hizmet verimini sınırladığını iddia ediyor. Belleğin yarısından fazlası statik olan model ağırlıkları tarafından alınır ve daha küçük bir kısmı isteklerin dinamik durumları tarafından alınır. Transformatörlerde bu dinamik durumlara, genellikle önceki tokenlardan bağlamı temsil eden KV önbelleği olarak adlandırılan dikkat mekanizmasıyla ilişkili anahtar ve değer tensörleri denir. KV önbelleği, üretilen token sayısına bağlı olarak zamanla dinamik olarak büyüyen ve küçülen bir yapıdır. Verimli bir şekilde yönetilmediğinde bu, sınırlı toplu boyuta ve dolayısıyla daha düşük verime yol açar. Genellikle mevcut sistemler iki büyük verimsizlik tarafından engellenir; birincisi dahili ve harici bellek parçalanması, ikincisi ise bellek paylaşımı için fırsatlardan yararlanamamadır.

vLLM, yeni bir teknik olan PagedAttention’ı tanıtarak bu darboğazları ele alır. İşletim sistemlerinde sayfalama ile sanal bellek kavramından esinlenen PagedAttention, anahtar ve değer tensörlerinin bitişik olmayan şekilde depolanmasını sağlayarak geleneksel dikkat mekanizmalarından farklıdır. KV önbelleğini tek bir sürekli parça olarak depolamak yerine, her biri belirli sayıda tokenı temsil eden sabit boyutlu bloklara böler. Dikkat gerçekleştirirken, PagedAttention çekirdeği yalnızca hesaplama için gereken ilgili KV bloklarını verimli bir şekilde bulur ve alır.

Dahası, vLLM, GPT, OPT, LLaMA gibi çeşitli boyutlardaki popüler LLM’leri destekler ve makalede yapılan değerlendirmelere göre vLLM, model doğruluğuna olumsuz bir etkisi olmadan, en son LLM’lere kıyasla LLM hizmet verimini 2-4 kat artırır. vLLM, aynı komuttan birden fazla çıktı dizisinin üretildiği paralel örneklemede önemli bir avantaj sağlar, bu durumda komut için hesaplama ve bellek, çıktı dizileri arasında paylaşılabilir. vLLM bu paylaşımı kolayca gerçekleştirebilir ve bellekten tasarruf sağlayabilir. Benzer şekilde, vLLM, paralel ışın işleme yoluyla ışın aramasında daha yüksek verimlilik, verim ve daha düşük gecikmeye yol açmıştır.

Karşılaştırma: vLLM vs Hugging Face Transformers vs TGI

vLLM geliştiricileri vLLM’nin verimini Hugging Face Transformers ve Text Generation Inference ile karşılaştırdılar ve vLLM’nin HF’ye kıyasla 24 kata kadar daha yüksek verim ve TGI’ye kıyasla 3,5 kata kadar daha yüksek verim elde ettiğini gördüler. Bu sonuçlar vLLM’nin LLM çıkarımında ve sunumunda performansı nasıl temelde değiştirdiğini vurgulamaktadır. Dönüştürücüler yüksek verim sağlamaz ve vLLM blogunda sağlanan görüntüde görüldüğü gibi vLLM sunumuna hala yetersiz kalan TGI tarafından iyileştirilirler.

vLLM'ler için kullanım alanları

Elde edilen performans iyileştirme düzeyi vLLM’yi şu gibi yüksek verimli üretim ortamları için ideal hale getirir:

● RAG sistemleri

● Sohbet robotu ve sanal asistanlar

● İçerik üretimi

● Otomatik çeviri

Son söz

vvLLM, çıkarım sırasında bellek ve hesaplamanın nasıl yönetildiğini yeniden düşünmesiyle öne çıkıyor. PagedAttention yeniliği sayesinde verimi, yanıt vermeyi ve kaynak verimliliğini önemli ölçüde iyileştiriyor. Ölçeklenebilir, verimli çıkarım talebi artmaya devam ettikçe, vLLM’lerin LLM dağıtımının geleceğinde büyüyen bir rol oynamaya hazır olduğunu söylemek doğru olur.

Referanslar

https://docs.vllm.ai/en/latest/

https://blog.vllm.ai/2023/06/20/vllm.html

https://dl.acm.org/doi/abs/10.1145/3600006.3613165

Daha Fazlasını Öğrenin

Sizin Gibi Çalışan Yapay Zeka (AI) Çalışanları İçin Şimdi Demo İsteyin

Ücretsiz Demonuza Erişmek İçin İletişime Geçin